Od Alana Turinga, borykającego się z problemem dostępu do odpowiednich komputerów, po Deep Blue ogrywający w szachowym meczu Garriego Kasparowa. Sztuczna inteligencja w ciągu kilku dekad rozwinęła się w niesamowity sposób. Jak doszliśmy jednak do miejsca, w którym nie dziwi jej obecność w naszej codzienności? Gdzie właściwie zacząć – od wspomnianego Turinga czy może… w starożytności? I dlaczego postępy w badaniach nad AI kilkukrotnie hamowały? Zapraszamy na podróż przez lata historii rozwoju sztucznej inteligencji.

Spis treści

Sztuczna inteligencja. Wszystko zaczyna się od Turinga…

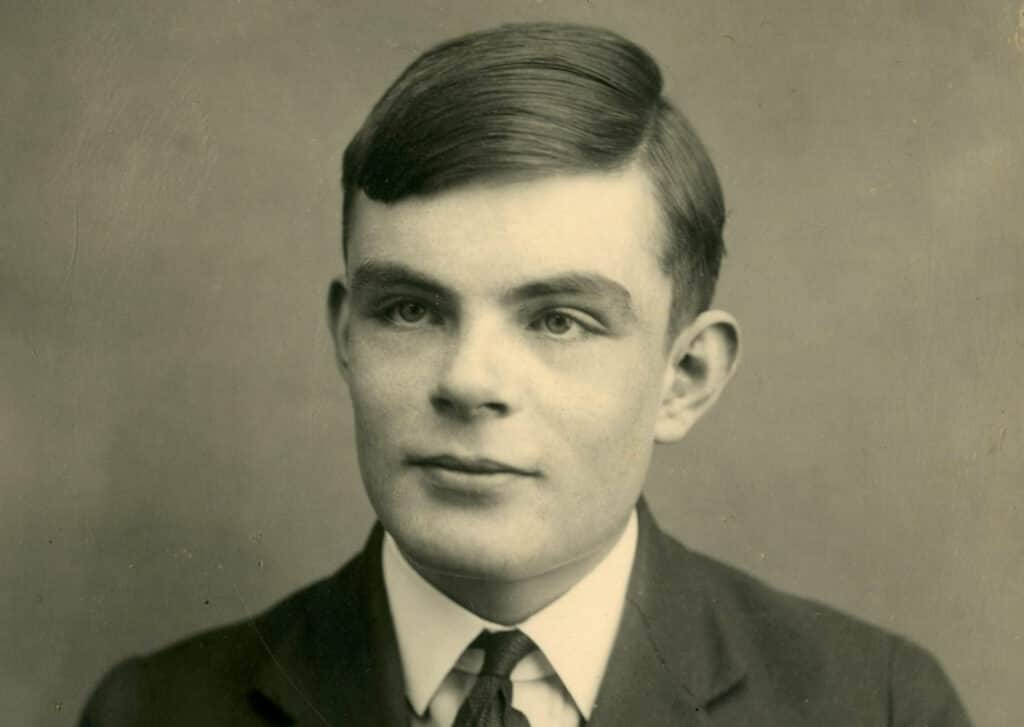

Alan Turing był geniuszem, obecnie nie trzeba do tego nikogo przekonywać. Znakomity uczony, który – opierając się na dokonaniach polskich kryptologów oraz matematyków – ostatecznie złamał niemieckie kody Enigmy, maszyny szyfrującej, ma też spore zasługi w dziele tworzenia sztucznej inteligencji. Dziś uważa się go wręcz za jej ojca.

Właściwie zaczęło się właśnie od Enigmy. Turing stworzył wtedy coś na kształt komputera o mocy 10 do potęgi 114 i w ten sposób złamał niemiecki kod. Jednak z całego procesu wysnuł wniosek, że przyszłość nauki może należeć nie do człowieka, a do algorytmów przez niego stworzonych, których zadaniem miałoby być przeprowadzanie skomplikowanych obliczeń.

Przeszkody w rozwoju tej myśli były trzy. Przede wszystkim kształt ówczesnych maszyn, przodków dzisiejszych komputerów. Te nie miały możliwości przechowywania pamięci, mogły tylko wykonywać powierzone im zadania – a co za tym idzie, nie były w stanie się uczyć. A to była podstawa myśli Turinga – przekonywał, że maszyny, jak i ludzie, mogą rozwijać się na bazie własnych doświadczeń, wyciągać i formułować logiczne wnioski, by na ich podstawie podejmować decyzje.

W dodatku używanie ówczesnych komputerów było wysoce kosztowne. Na początku lat 50. koszt wypożyczenia jednego takiego urządzenia mógł sięgać nawet 200 tysięcy dolarów… miesięcznie. Pozwolić na taki luksus sobie mogły tylko największe firmy technologiczne lub dotowane sporymi środkami uniwersytety, korzystające z komputerów do prac badawczych.

Trzeci, ostatni powód, jest już osobisty – w 1952 roku Turingowi wytoczono oficjalny proces ze względu na jego homoseksualność, która w tamtym czasie w Wielkiej Brytanii była nielegalna. W konsekwencji uczony dostał od sądu wybór: karę więzienia lub roczną kurację (składającą się z konsultacji z psychiatrą i terapii hormonalnej, w ramach której przyjmował estrogen, mający na celu chemiczną kastrację). Wybrał kurację.

Znacznie bardziej bolesne mogły być jednak dla niego konsekwencje akademickie – wskutek skazania stracił bowiem dostęp do poufnych informacji i odsunięto go od współprowadzonych przez niego badań. Nieco ponad dwa lata później wielki uczony popełnił samobójstwo.

Zostawił po sobie ogromną spuściznę, której najbardziej znanym elementem jest zapewne test Turinga lub, jak sam ją nazwał: Imitation Game (Gra w udawanie). Turing wysnuł wniosek, że maszyna będzie w pełni inteligentna, jeśli zda zaproponowany przez niego test. Ten miał polegać na zadawaniu zarówno maszynie, jak i ludzkiemu uczestnikowi, tych samych pytań. Maszyna i człowiek mieli odpowiadać w formie pisemnej (by nie zdradził ich głos), a kolejna, trzecia osoba miała prowadzić konwersację i analizować odpowiedzi.

Test za ostatecznie zdany mógłby zostać uznany wtedy, gdy zadający pytania nie byłby w stanie odróżnić odpowiedzi maszyny od tych, których udzielałby człowiek. Przez lata w mediach pojawiało się wiele informacji o tym, że test Turinga został finalnie zaliczony, badacze pozostają jednak sceptyczni i tłumaczą, że zwykle wynikało to z używania przez sztuczną inteligencję sztuczek – na przykład udawania chłopca, który niezbyt dobrze zna angielski. Z drugiej strony… to też świadczy o pewnej inteligencji, prawda?

Mimo wszystko możemy cieszyć się z faktu, że do tej pory żadna maszyna nie przeszła testu Turinga w pełni. W końcu sam jego twórca rzekł kiedyś, że:

– Wydaje się prawdopodobne, że po uruchomieniu metody myślenia maszynowego, nie zajmie im dużo czasu prześcignięcie naszych słabych mocy. Będą w stanie rozmawiać ze sobą, by poprawić swój spryt. Powinniśmy spodziewać się, że w pewnym momencie maszyny przejmą kontrolę.

…ale można zajrzeć i wcześniej

Turing, jak wspomnieliśmy, jest ojcem sztucznej inteligencji. Nie oznacza to jednak, że wcześniej o niej nie myślano. Wręcz przeciwnie, funkcjonowała ona – choć wtedy jej tak nie nazywano – w marzeniach uczonych od starożytności. Ludzie byli wówczas zafascynowani maszynami, które mogły samodzielnie wykonywać różnorakie zadania. Owszem, dziś wiemy, że opierały się one albo na zaawansowanych jak na tamte czasy mechanizmach, ale nie mających nic wspólnego z AI, albo na swego rodzaju iluzji samodzielności, podczas gdy w rzeczywistości za ruchy maszyny odpowiedzialny był sterujący nią człowiek.

Tak działały na przykład sterujące szachami roboty. Siedzący przy szachownicy gracz naprzeciwko siebie widział tylko maszynę, ale tą sterował ukryty przed oczami szachisty człowiek, który za pomocą systemu dźwigni przesuwał figurami na szachownicy. Zresztą nawet lata później – w 1770 roku – podobną maszynę skonstruował Wolfgang von Kempelen. Zwała się Turk, miała antropomorficzne kształty i zrobiła międzynarodową karierę. Przez 80 lat prezentowano ją właściwie na całym świecie.

W dążeniach ludzi do stworzenia samodzielnych, autonomicznych mechanizmów przez wieki widać było wielką wyobraźnię, ale i coś więcej. Ambicję. – Powinniśmy być jak bogowie. Powinniśmy odtworzyć największy cud Boga – stworzenie człowieka – pisał szwajcarski lekarz i filozof Paracelsus. A niespełna dwa stulecia później Kartezjusz przekonywał, że w przyszłości maszyny będą w stanie samodzielnie podejmować decyzje.

To również ich poglądy przyczyniły się do rozwoju sztucznej inteligencji. Choć wtedy – o czym za chwilę – nikt tak jeszcze tego nie nazywał.

Na późniejszy rozwój sztucznej inteligencji składa się też wiele dzieł, rozkładających na czynniki pierwsze procesy myślenia człowieka czy jego funkcjonowania. Należą do nich nawet książki science-fiction. Tym ostatnim zawdzięczamy choćby słowo „robot”, które stworzył czeski pisarz Karel Čapek w 1921 roku (od słowa robota, czyli, jak i po polsku: ciężka praca, harówka). Jeszcze ważniejsze zdają się jednak Trzy Prawa Robotyki, które w opowiadaniu „Zabawa w berka” zawarł Isaac Asimov, jeden z największych pisarzy science-fiction.

***

PRAWA ROBOTYKI ISAACA ASIMOVA

- Robot nie może skrzywdzić istoty ludzkiej lub – poprzez wstrzymanie się od działania – pozwolić, by stała jej się krzywda.

- Robot musi wykonywać rozkazy wydawane mu przez istoty ludzkie, z wyjątkiem sytuacji, kiedy byłyby one sprzeczne z Prawem Pierwszym.

- Robot musi chronić swoje istnienie dopóty, dopóki taka ochrona nie jest sprzeczna z Prawem Pierwszym lub Drugim.

W opowiadaniu „Roboty i Imperium” Asimov dodał później, nadrzędne wobec pozostałych, Prawo Zerowe:

- Robot nie może skrzywdzić ludzkości lub poprzez zaniechanie działania doprowadzić do uszczerbku dla ludzkości.

***

Jeszcze wcześniej istotne dla postępów w pracy nad sztuczną inteligencją były choćby dokonania George’a Boole’a, który w XIX wieku opracował pierwsze równania logiczne, później stanowiące podstawę koncepcji związanych z AI. Istotna w tej historii jest również postać Ady Lovelace, która modelowała skomplikowane obliczenia matematyczne. A także po części współtworzyła pierwszy „komputer” (przywołać tu wypada jeszcze Charlesa Babbage’a) zdolny do wykonywania obliczeń matematycznych. Z kolei na Harvardzie William Gray Walter i jego współpracownicy stworzyli sieci neuronowe. Walter w konsekwencji został ochrzczony – jak i później Turing – ojcem sztucznej inteligencji.

Idźmy dalej. Nikola Tesla pod koniec XIX wieku prezentował pierwszy na świecie model statku sterowany radiowo i mówił o „pożyczonym umyśle”, w który wyposażona jest łódź. W 1914 oku Leonardo Torres y Quevedo, hiszpański uczony, zaprezentował maszynę zdolną rozgrywać końcówkę partii w układzie król i wieża versus sam król. Bez udziału człowieka. W 1925 na (puste) ulice wypuszczono też pierwszy sterowany przez radio samochód. Jego jazda po Nowym Jorku zakończyła się sukcesem.

W 1929 roku z kolei – ledwie dwa lata po powstaniu filmu „Metropolis”, w którym przedstawiona jest pierwsza w historii kina postać robota, ochrzczonego imieniem Maria – Makoto Nishimura, japoński wynalazca, zaprezentował światu Gakutensoku, robota, który mógł ruszać głową, dłońmi i zmieniać wyrazy twarzy poprzez sterowane powietrzem mechanizmy. Pierwszego humanoidalnego robota stworzono za to dekadę później.

Zwał się Elektro, potrafił chodzić, mówić (znał ok. 700 słów nagranych na płyty), śpiewać, a nawet… palić papierosy. Jego operator porozumiewał się z nim za pomocą słów, ale ten ich nie rozumiał. Rozumiał za to elektryczne impulsy, na które przetwarzane były sylaby. Poprzez przekaźniki telefoniczne tak przetworzona informacja docierała do Elektro i przestawiała w jego mechanizmach odpowiednie przekładnie.

Co dalej? W 1943 roku Warren McCulloch (neuropsychiatra) i Walter Pitt (matematyk) publikują artykuł „A Logical Calculus of the Ideas Immanent in Nervous Activity”, w którym budują matematyczny model sieci neuronowych i pierwszy mechaniczny model mózgu. Tworzą go na podstawie kombinacji algorytmów oraz matematyki, starając się zrozumieć, jak działa ludzki umysł. W efekcie dowodzą, że mózg w zasadzie jest procesorem, który przetwarza informacje. A to już wpłynęło na dalszy rozwój sztucznej inteligencji.

Kilka lat później Edmund Berkeley pisze w swoim dziele „Giant Brains: Or Machines That Tink” takie słowa:

– W ostatnim czasie pojawiło się wiele wiadomości o dziwnych gigantycznych maszynach, które potrafią przetwarzać informacje z ogromną szybkością i umiejętnościami… Maszyny te są podobne do tego, czym byłby mózg, gdyby był wykonany ze sprzętu i drutu, zamiast ciała i nerwów… Maszyna potrafi obsługiwać informacje; może obliczyć, wnioskować i wybrać; może wykonywać rozsądne operacje za sprawą podanych jej informacji. Maszyna może więc myśleć.

Kluczowe jest tu, oczywiście, ostatnie zdanie. Maszyna rzeczywiście mogła myśleć. I coraz częściej to udowadniano.

Zrobiono to na przykład jeszcze w latach 40., gdy powstał ENIAC (Electronic Numerical Integrator and Computer), czyli pierwszy komputer elektroniczny, który używany był do celów ogólnych. Dzieło Johna Prespera Eckerta i Jona Mauchly’ego z Uniwersytetu w Pensylwanii miało obliczać parametry ostrzału dla armii USA w wojnie z Niemcami. Zresztą nic w tym dziwnego – rozwój nauki często szedł w parze z wojnami.

W przypadku sztucznej inteligencji nie było inaczej. Choć nadal nikt tak tego nie nazywał.

Powstaje „sztuczna inteligencja”

W 1951 roku Marvin Minsky i Dean Edmonds budują SNARC (Stochastic Neural Analog Reinforcement Computer), czyli pierwszą w świecie sztuczną sieć neuronową. Cztery lata później pierwszy z nich – zresztą jeden z najważniejszych teoretyków oraz praktyków rozwoju AI – pisze:

– Maszyna może zostać „wyszkolona” poprzez metodę „prób i błędów” do osiągnięcia jednej z wielu funkcji wyjścia-wejścia. Taka maszyna, umieszczona w odpowiednim środowisku, gdy otrzyma kryterium „sukcesu” lub „porażki”, może zostać wyszkolona tak, by prezentowała zachowanie „poszukiwania celu”.

Co to oznacza? Że modele matematyczne budowane przez algorytmy uczenia maszynowego (machine learning – na marginesie: termin ten ukuł w 1952 roku Arthur Samuel, po publikacji autorskiego programu szachowego) są tworzone na odpowiednich danych w celu podejmowania decyzji bez potrzeby zaprogramowania maszyny do ich podjęcia. I to podstawowa różnica między takimi algorytmami czy modelami a, dajmy na to, zwykłym kalkulatorem, w którym wynik działania jest z góry określony. Sztuczna inteligencja ten wynik tworzy sama.

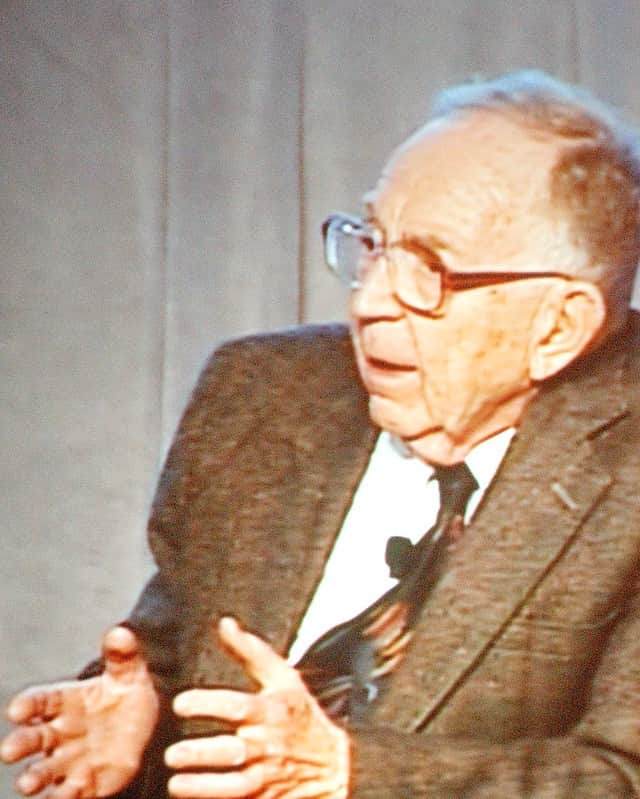

I tu dochodzimy do Konferencji w Dartmouth, zebrania najtęższych umysłów tamtych czasów, zwołanego przez Johna McCarthy’ego.

McCarthy był amerykańskim informatykiem, który w 1950 roku na zlecenie marynarki wojennej USA rozpoczął prace nad sztuczną inteligencją, rozwijając w ich trakcie czy to uczenie maszynowe, czy sieci neuronowe. W konsekwencji tego rozwoju powstały programy komputerowe, które sprawdziły się między innymi w początkach amerykańskiego programu kosmicznego. Sam McCarthy opublikował pierwszy język programowania AI, czyli LISP (LISt Processing), a w tym samym roku powstał też pierwszy program AI, The Logic Theorist.

Wróćmy jednak do konferencji. Na tej stawiło się bowiem wielu wybitnych naukowców z najważniejszych uniwersytetów. Do historii przeszło przede wszystkim to, że to właśnie w Dartmouth przedstawiono definicję sztucznej inteligencji, uznając, że to „system, który świadomie postrzega otoczenie i reaguje na nie tak, aby zmaksymalizować swoje szanse powodzenia”. Stwierdzono również, że możliwe jest odtworzenie ludzkiej inteligencji w sztucznym systemie.

Sam McCarthy ostatecznie – mimo że przeszła ona do historii jako istotne wydarzenie w rozwoju AI – był ponoć zawiedziony konferencją. Choć bowiem zaprezentowano tam kilka przełomowych odkryć (choćby wspomniany The Logic Theorist), to ostatecznie nie udało się uzgodnić nawet podstawowych metod działania, mających doprowadzić do rozwoju na polu sztucznej inteligencji. Jedyne, co naprawdę wyniesiono z Dartmouth, to przekonanie, że stworzenie AI jest jak najbardziej osiągalne.

I to wystarczyło, by napędzić badania na kolejnych 20 lat.

Dwie szkoły. Symboliści i koneksjoniści

Konferencja w Dartmouth ostatecznie nie tylko nie rozwiązała wszelkich problemów środowiska naukowego, ale niektóre wręcz pogłębiła. Takim był choćby spór dwóch nurtów prac nad rozwojem sztucznej inteligencji, jakie istniały w tamtych latach. Jednym byli symboliści, drugim koneksjoniści. Zacznijmy od drugich.

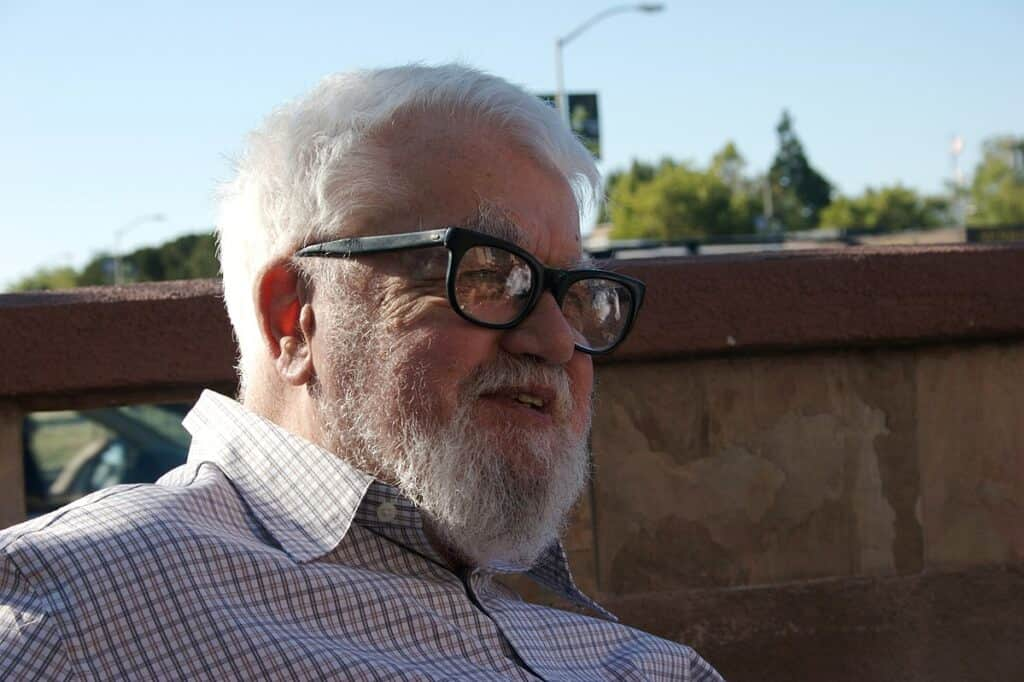

Koneksjoniści – z Geoffreyem Hintonem, naczelnym zwolennikiem tej metody, na czele – starali się stworzyć programy samouczące się, oparte na modelach sieci neuronowej, o której już wspominaliśmy. Do tego opracowywali odpowiednie procedury „uczenia” tego typu programów czy rozwiązywania postanowionych przed nimi zadań. Szukali więc rozwiązań opartych na tym, co wiadomo było o ludzkim mózgu, uznając, że podobnie musi działać sztuczna inteligencja.

Jednym z jej przykładów, opartych na zasadach koneksjonizmu, był perceptron, skonstruowany przez Franka Rosenblatta i zaprezentowany marynarce wojennej USA w 1957 roku. „New York Times” pisał potem o nim, że to „zarodek elektronicznego komputera, od którego marynarka oczekuje, że ten będzie z czasem w stanie chodzić, mówić, pisać i być świadomym swojego istnienia”. Ujmując rzecz technicznie, był on prostą siecią neuronową, zdolną rozpoznawać znaki alfanumeryczne. Co jednak istotne w skład jego działania wchodził też proces uczenia, przez co z czasem zaczęto testować perceptrony przy innych zadaniach (na przykład: na klipie poniżej – w rozpoznawaniu płci osoby na zdjęciu).

– By zaangażować sztuczną inteligencję do pracy, musimy wykonać obliczenia bardzo podobne do ludzkiego mózgu – mówił Hinton, dziś uważany za „ojca chrzestnego” AI. Choć równocześnie sam przyznawał, że „przyszłość należy zapewnedo studenta, który będzie bardzo podejrzliwy wobec wszystkiego, co powiedziałem”. Bo i faktycznie, na zasadach podobnych do tych proponowanych przez Hintona działa dziś choćby deep learning (uczenie głębokie), ale różni się jednak od tego, jak funkcjonuje ludzki mózg.

***

DEEP LEARNING

Technika uczenia maszynowego, w której tworzy się głębokie sieci neuronowe. Za ich pomocą maszyna ma doskonalić swoje umiejętności. Deep learning wykorzystuje się między innymi do automatycznego przetwarzania i rozpoznawania mowy, rozpoznawania obrazów czy przetwarzania języka naturalnego. Używana jest też między innymi przez czatboty czy autonomiczne samochody.

***

Różnica polega na tym, że choć sztuczne sieci neuronowe są zaprojektowane na podstawie tych w ludzkim mózgu, to cała konstrukcja jest ostatecznie znacząco uproszczona. Komputery do nauki potrzebują też ogromnej ilości danych, człowiekowi często wystarczą strzępki informacji, jakie otrzymuje. Podobnie jest z energią – dużo więcej zużywają jej maszyny. Co nie zmienia faktu, że deep learning wykorzystuje się aktualnie z powodzeniem na całym świecie.

Nie zawsze tak było. Po Konferencji w Dartmouth skłaniano się raczej ku Symbolizmowi, którego głównym propagatorem był Marvin Minsky. Symboliści uznawali, że maszyna nigdy nie będzie zdolna do samodzielnego myślenia, dlatego trzeba ją wcześniej zaprogramować tak, by jej zachowanie przypominało to człowieka, ale dla konkretnych funkcji. Stąd tworzy się modele matematyczno-logiczne i ustala swego rodzaju zasady, za pomocą których sztuczna inteligencja ma analizować przedstawione jej problemy.

Wkrótce Minsky (wraz z McCarthym) uzyskał dofinansowanie od rządu Stanów Zjednoczonych, a jego koncepcja stała się wiodącą na kolejnych 20 lat. A on sam stał się znany na tyle, że gdy Stanley Kubrick kręcił „Odyseję kosmiczną”, to właśnie Minsky doradzał mu na temat tego, jak przedstawić w filmie HAL-a 9000, superinteligentny komputer.

Dobre czasy, by zajmować się AI

Okres od 1956 do 1973 roku często nazywa się „latem AI”. W tym okresie sztuczną inteligencję widziano jako przyszłość i inwestowano w badania nad jej rozwojem potężne pieniądze, głównie rządowe. Optymistyczne (jak się potem okazało aż za bardzo) były też prognozy samych badaczy.

Miały zresztą swe uzasadnienie – komputery w tamtych latach rozwijały się naprawdę szybko. Choć nie sposób dziś nie zauważyć, że słowa Minsky’ego, który w 1970 roku mówił „Life”, że „za trzy do ośmiu lat będziemy mieć maszynę z ogólną inteligencją przeciętnego człowieka” zdecydowanie się nie sprawdziły. Częściowo przez możliwości techniczne ówczesnych komputerów, a częściowo przez ograniczenia tak zwanych rule-based systems (systemów opartych na regułach).

To one w latach 60. i 70. stały się znaczącym rejonem poszukiwań w badaniach nad sztuczną inteligencją. Systemy te można było zaprogramować, by radziły sobie z zaawansowanymi problemami, rozbijając je na zestawy reguł, za którymi komputer mógłby podążać. Dla ich działania wykorzystywano wiedzę i ekspertyzę ludzkich ekspertów, którą kodowano komputerowi właśnie jako zestaw reguł, jakie ten mógłby potem wykorzystać do rozwiązania podobnych problemów.

To wszystko miało jednak swoje ograniczenia, szczególnie gdy przychodziło do radzenia sobie z niepewnością czy niejasnością zaprezentowanych maszynie zadań. Mimo tego jednak tego typu systemy pokazały, że możliwe jest użycie ludzkiej wiedzy do zaprogramowania komputera, by rozwiązywał postawione przed nim problemy. W pewnym sensie wybudowano dzięki temu drogę, którą potem podążali inni badacze, stawiając kolejne kroki na drodze ku sztucznej inteligencji.

Albo tworząc programy czy maszyny, którym warto się przyjrzeć. W czasie pierwszego lata AI powstały bowiem między innymi:

- ELIZA, czyli pierwszy chatbot. Choć wtedy nikt nie używał jeszcze tego słowa (powstało ono w 1994 roku), to ELIZA właśnie tym była. Joseph Weizenbaum, niemiecki informatyk pracujący na MIT w USA był zafascynowany testem Turinga. W 1966 roku stworzył wirtualną psychoterapeutkę, która była w stanie rozmawiać z ludźmi. ELIZA najpierw zadawała pytanie, a potem w odpowiedziach ludzi rozpoznawała kluczowe słowa, dzięki którym ciągnęła konwersację. Na przykład na słowo „matka” padała prośba o to, by pacjent opowiedział więcej o swojej rodzinie. ELIZA nie była zresztą tylko rozwiązaniem teoretycznym – wręcz przeciwnie. Zaangażowano ją (i to z powodzeniem!) do faktycznych terapii osób z zaburzeniami psychicznymi, uprzedzając ich jednak o tym, że rozmawiają z maszyną. Po sukcesie ELIZY powstały inne tego typu chatboty: PARRY (1972), Racter (1983) czy Jabberwocky (1997).

- SHRDLU, czyli wirtualny mikroświat. To przykład sztucznej inteligencji zdolnej odpowiadać na pytania, notować informacje w oknie dialogowym, a nawet wykonywać polecenia. Maszyna za pomocą wirtualnego chwytaka mogła we wspomnianym mikroświecie przenosić kolorowe bloki. By to zrobić, była w stanie przeprowadzić analizę składniową, semantyczną i gramatyczną poleceń w języku angielskim. Zapamiętywała również – a na polecenie nawet omawiała – swoje plany działania. Po wpisaniu „SHRDLU” na angielskiej Wikipedii (tak, tam też czasem zagląda się przy riserczu), znajdziecie tam przykład długiego dialogu człowieka z komputerem, wykonującym jego polecenia.

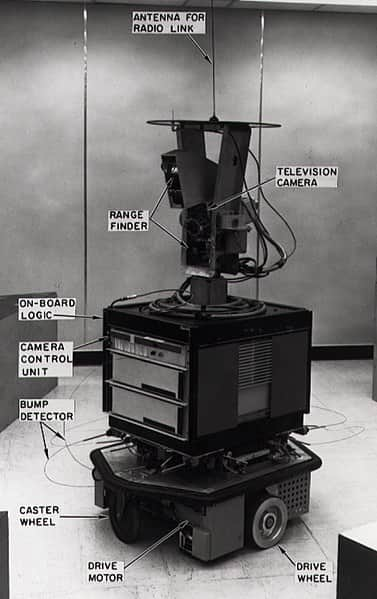

- Shakey, czyli robot. Pierwszy na świecie taki, który potrafił samemu podejmować decyzje o swoim postępowaniu, na podstawie wnioskowania o otoczeniu. Przed poruszeniem się tworzył mapę przestrzenną tego, co widzi. Powstał w podobnym okresie co SHRDLU (końcówka lat 60.) i budził spore zainteresowanie. Główna wada? Był piekielnie wolny, po każdym ruchu musiał aktualizować mapę, a to zajmowało nawet godzinę. Wystarczyło też, by w jego polu widzenia znalazł się jakikolwiek ruchomy obiekt, by Shakey nie był w stanie zaplanować kolejnego ruchu.

- MYCIN, czyli system diagnostyki medycznej. Dzieło Edwarda Shortliffe’a, który równocześnie był lekarzem i informatykiem. MYCIN to system doradzający lekarzom, mający na celu pomóc im dobrać odpowiednią terapię antybiotykami. W latach 70. XX wieku przepisanie komuś antybiotyków zwykle wymagało konsultacji ze specjalistą, bowiem każdy z tego typu leków wywoływał określone skutki uboczne i działał na określoną grupę bakterii. „Zwykli” lekarze nie mieli jeszcze na ten temat wystarczającej wiedzy. MYCIN gromadził ją w obszernej bazie danych, miał też zaprogramowanych 500 zasad pomagających lekarzom dobrać odpowiednie antybiotyki. W dodatku radził sobie z niekompletnymi danymi, a nawet uzasadniał rady, jakie udzielał lekarzom.

- DENDRAL, czyli to samo, tylko w chemii. Zaprojektowany przez Joshuę Lederberga system miał pomagać chemikom w zidentyfikowani struktury molekularnej związków organicznych. Co istotne – poprzez informację zwrotną, jaką otrzymywał od użytkowników, był w stanie udoskonalać i poprawiać odpowiedzi, jakich udzielał.

- Projekt CYC, czyli dedukcja. Rozwijany nieprzerwanie od 1984 roku (mimo że pierwotnie miał trwać 10 lat) projekt, który został zaprogramowany tak, by uczył się nowych faktów, ale nie dzięki obserwacji świata, a na podstawie dedukcji z podstawowych faktów już mu znanych i znajdujących się w jego bazie danych lub ze źródeł pisanych (na przykład stron internetowych).

To oczywiście tylko część osiągnięć pierwszego lata AI. Wspomnieć można jeszcze WABOT-1, robota stworzonego w Japonii, mającego systemy kontroli kończyn, konwersacji czy też wizyjny. Wszystkie te przełomowe odkrycia działały jednak albo w bardzo wąskiej dziedzinie, albo rozbijały się o możliwości ówczesnych komputerów. Dlatego z czasem słońce lata zaczęło świecić coraz słabiej i krócej.

Po lecie nadchodzi zima

Zima nadeszła głównie przez rozczarowanie inwestorów. Mimo znaczących sukcesów na polu sztucznej inteligencji – a takimi były choćby ELIZA czy MYCON – uznano, że wkładane w rozwój AI środki nie zawsze przynosiły oczekiwane rezultaty. Tak więc po lecie AI pojawił się okres rozczarowania dotychczasowymi dokonaniami, nazywany właśnie zimą AI. Trwała ona od 1974 do 1980 roku, a w jej trakcie inwestorzy wycofali się z finansowania badań.

Tworzyło to swego rodzaju błędne koło, bowiem brak postępów takich, jak zapowiadane, wynikał w dużej mierze z bariery technologicznej – potrzebne były lepsze, szybsze i bardziej wydajne komputery, które… trudno było stworzyć, gdy nie miało się zaplecza finansowego. – Komputery były wręcz o milion razy za słabe, by móc zaprezentować inteligencję – mówił Hans Moraves, doktorant Johna McCarthy’ego.

Zapowiedzią zimy AI stało się wycofanie przez rząd USA finansowania badań sztucznej inteligencji, które nastąpiło w 1969 roku. Co prawda jeszcze przez cztery lata nie było to aż tak odczuwalne, jednak z czasem – gdy wycofali się też pozostali inwestorzy – przyczyniło się nie tylko do spowolnienia rozwoju badań nad AI, ale też do wykreowania publicznego obrazu sztucznej inteligencji jako konceptu wyciągniętego żywcem z książek science-fiction, a nie czegoś realnego.

Do tego wszystkiego Marvin Minsky i Seymour Papert w 1969 roku opublikowali „Perceptrons: An Introduction to Computational Geometry”, gdzie podkreślali i analizowali ograniczenia prostych sieci neuronowych. Wielu naukowców uznawało potem, że – wespół z raportem jednej z brytyjskich uczelni, w którym powiedziano wprost, że postęp w pracach nad AI jest mizerny – stało się to pretekstem do wycofania finansowania badań. Minsky i Papert w kolejnym wydaniu (z 1988 roku) odpierali takie zarzuty.

– Uważamy, że progres dotarł wtedy do ściany, brakowało bowiem odpowiednich podstawowych teorii. W połowie lat 60. było wiele wspaniałych eksperymentów z perceptronami, ale nikt nie był w stanie odpowiednio wytłumaczyć, dlaczego były one w stanie rozpoznać konkretne rodzaje wzorów, a inne nie – pisali. Sugerowali więc, że dla dalszego rozwoju AI były potrzebne były w pierwszej kolejności odpowiednie teorie, a dopiero z czasem – bardziej zaawansowane technologie.

To wszystko nie oznacza jednak, że tych nie tworzono. Warto wspomnieć choćby dwie z nich.

W 1979 roku Stanford Cart przemierzył wypełniony krzesłami pokój bez asysty człowieka. Zajęło mu to co prawda pięć godzin, ale był to jeden z najwcześniejszych przykładów całkowicie autonomicznego pojazdu. W Japonii zbudowano z kolei drugą wersję Wabota, który był zdolny porozumiewać się z człowiekiem czy też odczytać zapis nutowy i zagrać na jego podstawie melodię.

Sztuczna inteligencja rozwijała się więc cały czas, tylko wolniej. Czekała na swój moment.

Komercyjny przełom

Ożywienie przyszło, gdy okazało się, że AI może pomóc zarabiać bądź oszczędzać pieniądze. Czyli wtedy, gdy zrozumiano, że sztuczną inteligencję da się wykorzystać do celów komercyjnych. W 1981 roku Ed Feigenbaum i jego współpracownicy opracowali tak zwane systemy eksperckie. Te nie koncentrowały się już na ogólnej inteligencji maszyny, a zamiast tego automatyzowały konkretne zadania i decyzje.

Pierwsze rozwiązanie stworzone w ten sposób – nazwane RI – wprowadziła do swojej działalności firma Digital Equipment Corporation. Miało jej ono pomóc w konfigurowaniu zamówień firmy i poprawieniu ich dokładności. Pięć lat po wdrożeniu RI do swojej działalności, przedsiębiorstwo oszczędzało za sprawą tego systemu 40 milionów dolarów rocznie.

Na fali ekscytacji nowymi możliwościami, finansowanie badań nad rozwojem AI i komputerów do obsługi sztucznej inteligencji na powrót wprowadziły Japonia, Wielka Brytania, duża część Europy i USA, które nie zamierzały zostać w tyle. Cały ten entuzjazm skończył się jednak szybko, bo dwie firmy – Apple i IBM – ledwie kilka lat później wprowadziły na rynek komputery, mające większą moc obliczeniową od tych, jakich używano do obsługi sztucznej inteligencji.

Po klęskach wielu projektów po obu stronach świata, ponownie wstrzymano więc finansowanie. Tym razem jednak nie zastopowało to rozwoju AI.

Lata 80. to przede wszystkim znaczący rozwój wspomnianych systemów eksperckich. W ramach tych drugich chciano z czasem zmagazynować jak największą wiedzę i dzielić się nią z użytkownikami. A ich opracowanie sprawiło, że na polu sztucznej inteligencji postawiono w tamtych latach nacisk na to, by ta była prosta w obsłudze, ale mogła służyć ludziom. Dobrym przykładem opracowanego w tamtych latach systemu eksperckiego były programy pozwalające sprawdzić kredyty bankowe.

Na rozwój AI w latach 80. wpłynęło też jednak odrodzenie konekcjonizmu, które nastąpiło w tamtym okresie. Rozwinięto wtedy sposób użycia sieci neuronowych i technik uczenia maszynowego, odchodząc tym samym od stosowanych wcześniej rule-based systems. Zmiana ta gwarantowała nowe możliwości w rozwoju sztucznej inteligencji, dzięki tworzeniu maszyn, które mogły się uczyć i adaptować do nowych sytuacji z czasem poprzez kreowanie odpowiednich algorytmów. Tak stworzone maszyny mogły same się ulepszać – pozyskując więcej danych udoskonalały swoje działania. Choćby pod kątem rozpoznawania obrazów, które w latach 90. było jednym z głównych obiektów zainteresowań badaczy.

Tak więc, choć druga zima nadeszła i trwała sześć lat (1987-1993), nie zdołała zatrzymać rozwoju badań nad sztuczną inteligencją. Nie zrobił tego też rozwój osobistych komputerów, które wyparły z rynku choćby wczesne systemy eksperckie (te szybko stały się wolne, przestarzałe i zbyt kosztowne w utrzymaniu, zwłaszcza, że trudno je było aktualizować, a same nie potrafiły się „uczyć”). AI niezmiennie stawało się bardziej zaawansowane.

Skok w XXI wiek

W kolejnych latach wielki skok w rozwoju zanotowano choćby przy NLP (Natural language processing), czyli przetwarzaniu ludzkiego języka na taki, który będzie zrozumiały dla komputerów i maszyn. Pomogły w tym, oczywiście, algorytmy uczenia maszynowego i deep learningu, dzięki którym komputer sam mógł uczyć się języków na prezentowanych mu przykładach, a w końcu odgrywać nawet rolę tłumacza, w której zresztą komputery cały czas się rozwijają.

W latach 90. powstali też inteligentni agenci, pomagający na przykład w przeglądaniu sieci czy zakupach online. Część z nich czasem nazywa się po prostu botami, wiele pełniło funkcję swego rodzaju wirtualnych asystentów dla użytkownika.

Najbardziej medialne były jednak zapewne inne osiągnięcia – te związane z grami. Dziś komputery potrafią wygrać z człowiekiem w Jeopardy! (taki eksperyment, w którym komputer Watson pokonał dwóch byłych mistrzów teleturnieju, zorganizowano w 2011 roku, zobaczycie go w klipie poniżej, zwróćcie uwagę na finalną odpowiedź Kena), GO (uznawanej za najtrudniejszą logiczną grę świata, program AlphaGo w 2015 roku pokonał Lee Se-dola, 15-krotnego mistrza świata, w strategia AI nie była uprzednio programowana, a wypracowana na bazie doświadczenia) i w szachach.

Sensacją był ostatni z tych „występów”, a chronologicznie – najwcześniejszy.

W 1997 roku komputer Deep Blue pokonał bowiem samego Garriego Kasparowa, uważanego za jednego z najwybitniejszych (najwybitniejszego?) szachistów w dziejach (kilka lat wcześniej Chinook, zaprogramowany do gry w warcaby, mierzył się z Marionem Tinsleyem, komputer wygrał dwie partie, ale przegrał cały mecz). Choć sam arcymistrz oskarżył twórców o oszustwo, sugerując, że gra ich maszyny była „zbyt ludzka” i musiał kontrolować ją człowiek, to reszta świata spisku nie szukała. Uznano, że maszyna wygrała uczciwie, co stało się wielkim sukcesem sztucznej inteligencji.

***

KRÓTKA SZACHOWA CHRONOLOGIA ROZWOJU AI

- 1948. Pierwsze programy szachowe.

- 1951. Alan Turing pisze, że „nikt nie może ułożyć programu lepszego od swojego poziomu gry”.

- 1967. Komputer po raz pierwszy wygrywa z szachistą podczas turnieju.

- 1977. Komputer pokonuje mistrza klasy międzynarodowej, w jednej partii.

- 1997. Deep Blue pokonuje Kasparowa wynikiem 3,5:2,5.

- 2003. Deep Junior (zwykły komputer, nie specjalnie przygotowana maszyna) remisuje z Kasparowem 3:3, mimo że mecz rozegrano na ustalonych przez niego warunkach. Arcymistrz mógł choćby trenować z maszyną przez dłuższy czas przed właściwym meczem, by poznać jego słabsze strony.

- Dziś. Programy szachowe grające na poziomie arcymistrzów może mieć każdy w swoim telefonie, wystarczy kilka sekund.

***

A że w tym samym czasie upowszechniał się Internet i rynek komputerów osobistych (z czasem i laptopów), a do tego wzrosła moc obliczeniowa, to badania AI wkroczyły w kolejną, nową fazę. Dzięki temu komputery coraz częściej są w stanie wygrywać z człowiekiem w „ludzkich” pojedynkach – czyli tam, gdzie liczy się nie tylko wiedza, ale też doświadczenie, logika czy intuicja. Różnego rodzaju gry logiczne to tego najlepszy dowód (choć wiele osób sugeruje, że np. w przypadku szachów to efekt nie poziomu sztucznych szachistów, a szybkości wykonywanych przez nie ruchów).

Faktem pozostaje jednak, że dziś AI nie tylko spotykamy w niemal każdej dziedzinie naszego życia, ale też, że maszyny są coraz bliżej przejścia testu Turinga, prowadzą autonomiczne pojazdy, istnieją systemy, które ogrywają też pokerzystów i potrafią przy tym blefować (!), stworzono program, który zdał egzaminy na studia medyczne, a kostkę Rubika sztuczna inteligencja potrafi ułożyć w nieco ponad sekundę, podczas gdy ludzki rekord świata wynosi w tej chwili 3.47 s.

W dwóch słowach: wyprzedza nas.

SEBASTIAN WARZECHA

***

Wykorzystane źródła: BBC, Dataversity.net, Forbes, FreeCodeCamp, Inteligencjasztuczna.pl, Internet Encyclopedia of Philosophy, Harvard University (kilka portali uniwersyteckich), History of Data Science, Medium.com, Sibiz.pl, Sii.pl, Sztucznainteligencja.org.pl, Tableau.com, Towards Data Science, Uniwersytety: Jagielloński, Śląski i Warszawski (ich portale oraz podstrony) oraz dzieła (lub ich streszczenia) przytoczonych autorstwa przywoływanych w artykule naukowców i filozofów.

***

CZYTAJ WIĘCEJ O SZTUCZNEJ INTELIGENCJI:

WIĘCEJ O SZTUCZNEJ INTELIGENCJI:

- „Moim marzeniem jest być przy stoliku, który zmienia świat”. Wywiad z Jarosławem Królewskim

- Co sztuczna inteligencja podpowiada Santosowi? Plan AI na reprezentację Polski

- W jaki sposób kluby Premier League korzystają ze sztucznej inteligencji?

- „Bałabym się prób genetycznego ulepszania człowieka”. Wywiad z prof. Ewą Bartnik

- Analiza obrazu, polski „InStat”, sztuczna inteligencja szukająca juniorów. PZPN otwiera się na innowacje

- Nie zaprogramujemy meczu. Piłkarze nie będą robotami